Spis treści

Co to jest kod binarny?

Kod binarny to sposób zapisu liczb, w którym używa się jedynie dwóch znaków: 0 i 1. Jest to system pozycyjny, co oznacza, że wartość każdej cyfry zależy od jej miejsca w ciągu. Na przykład w liczbie binarnej 101, mamy:

1*2^2 + 0*2^1 + 1*2^0, co w rezultacie daje 5. Ten system ma ogromne znaczenie dla elektroniczny cyfrowej oraz informatyki, ponieważ:

- pozwala na efektywne przetwarzanie i przechowywanie danych,

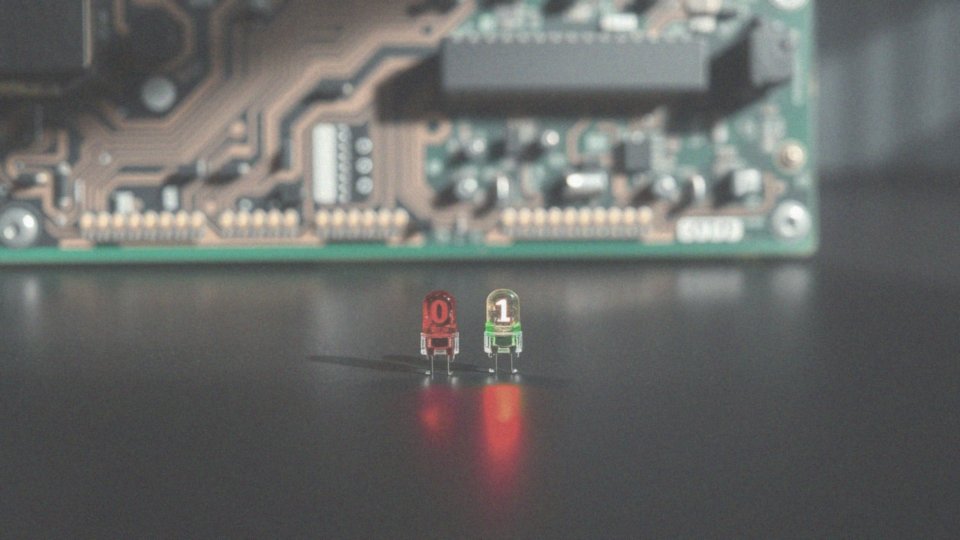

- cyfry 0 i 1 odpowiadają różnym stanom w obwodach elektronicznych,

- 0 oznacza wyłączenie, a 1 – włączenie,

- ułatwia to projektowanie złożonych procesów obliczeniowych na poziomie sprzętowym,

- jest fundamentem programowania, umożliwiając reprezentację danych w sposób, który pozwala komputerom na edytowanie i analizowanie informacji.

Dlaczego system dwójkowy jest ważny?

System dwójkowy odgrywa niezwykle istotną rolę w funkcjonowaniu komputerów oraz wszystkich urządzeń cyfrowych. Umożliwia on przedstawianie informacji za pomocą zer i jedynek, co odpowiada stanom prądu: wyłączonemu i włączonemu w obwodach elektronicznych. Stanowi on fundament wszelkich operacji logicznych, które realizują komputery, i jest bazą elektroniki cyfrowej.

Dzięki zdolności przetwarzania i przechowywania danych, urządzenia cyfrowe mogą wykonać skomplikowane obliczenia oraz operacje na rozległych zbiorach informacji. W obszarze informatyki system binarny jest absolutnie niezbędny podczas programowania i tworzenia algorytmów, gdyż jego proste zasady działania umożliwiają projektantom konstruowanie efektywnych układów elektronicznych.

Taki rozwój przekłada się na lepszą wydajność technologii. Zrozumienie systemu binarnego jest kluczowym elementem dla wszystkich osób pracujących w branży informatycznej czy elektronicznej. Jego znaczenie nieustannie rośnie wraz z rozwojem technologicznym, gdyż nowoczesne technologie w ogromnym stopniu opierają się na tej podstawowej koncepcji.

Jak działa system binarny?

System binarny opiera się na potęgach liczby 2. Każda cyfra w tym systemie ma przypisaną wagę, która odpowiada konkretnej potędze, na przykład:

- 2^0,

- 2^1,

- 2^2,

- itd.

Aby określić wartość liczby binarnej, wystarczy zsumować potęgi, dla których cyfra przyjmuje wartość 1. Na przykład, liczba binarna 1101 oblicza się jako 1*2^3 + 1*2^2 + 0*2^1 + 1*2^0, co w systemie dziesiętnym daje nam wynik 13.

Operacje na liczbach binarnych są analogiczne do tych w systemie dziesiętnym, ale ograniczone do dwóch cyfr: 0 i 1. Do najczęściej wykonywanych działań należą:

- dodawanie,

- odejmowanie,

- mnożenie,

- dzielenie,

- które zawsze respektują zasady systemu dwójkowego.

W kontekście technologii komputerowej system binarny pełni kluczową funkcję. Komputery operują na danych zapisanych w formacie zer i jedynek, co umożliwia skuteczne przetwarzanie informacji. Dzięki tej prostej, ale potężnej koncepcji, urządzenia cyfrowe są zdolne do realizacji złożonych obliczeń. Programiści korzystają z tego, projektując oprogramowanie i algorytmy, które są wydajne oraz zgodne z architekturą komputerów.

Zrozumienie systemu binarnego jest kluczowe dla każdego profesjonalisty w dziedzinie informatyki, ponieważ stanowi fundament nowoczesnych technologii i aplikacji komputerowych. Nie tylko pozwala na efektywne przechowywanie i przetwarzanie danych, ale także jest podstawą bardziej złożonych systemów, w tym języków programowania oraz struktur danych.

Jakie są podstawowe jednostki w systemie binarnym?

W systemie binarnym kluczowymi jednostkami są bit i bajt. Bit to najprostsza forma, która reprezentuje jedną cyfrę w systemie binarnym: 0 lub 1. Te maleńkie elementy są fundamentem dla szybkiego zapisywania informacji oraz komunikacji w świecie cyfrowym.

Ośmio-bitowe grupy tworzą bajt, który odgrywa ważną rolę w reprezentacji znaków, liczb oraz różnorodnych danych w komputerach. Bajty można łączyć w większe jednostki, takie jak:

- kilobajty,

- megabajty,

- gigabajty.

Warto wiedzieć, że:

- 1 kilobajt to 1024 bajty,

- 1 megabajt to 1024 kilobajty,

- 1 gigabajt to 1024 megabajty.

Te jednostki są istotne nie tylko dla przechowywania informacji w pamięci RAM czy na dyskach twardych, ale także w kontekście przesyłania danych. Bity znajdują zastosowanie przy transferze danych przez Internet, zapisywaniu plików multimedialnych oraz kodowaniu znaków w różnych dokumentach. Zrozumienie tej tematyki jest niezwykle istotne dla programistów, inżynierów oraz wszystkich, którzy pracują w obszarze technologii komputerowej.

Co oznacza bit?

Bit, znany również jako cyfra binarna, stanowi najważniejszą jednostkę informacji w systemie binarnym. Może przyjmować jedynie dwie wartości: 0 lub 1. Jako najprostsza forma danych, odgrywa niezwykle istotną rolę w architekturze komputerowej oraz w procesie przetwarzania informacji. Bity są niezbędne dla operacji logicznych i arytmetycznych, a ich znaczenie dla działania procesorów oraz budowy pamięci, takiej jak RAM i ROM, jest nie do przecenienia.

Każdy bit reprezentuje określony stan w obwodach elektronicznych, co oznacza, że może być interpretowany jako włączenie (1) lub wyłączenie (0) elementu w obwodzie. Te małe jednostki mają fundamentalne znaczenie dla kodowania danych. Kiedy łączymy je w grupy, powstają większe jednostki, na przykład bajty, które składają się z ośmiu bitów. Taki system hierarchii umożliwia efektywne przedstawianie bardziej skomplikowanych danych, w tym liczb, znaków czy obrazów.

W dziedzinie informatyki zrozumienie bitów jest kluczowe dla programistów oraz inżynierów, którzy projektują algorytmy i systemy informatyczne. Bez tej wiedzy trudno efektywnie zarządzać pamięcią komputera. To właśnie bity stanowią fundament, na którym opiera się cała informatyka.

Jakie znaczenie mają bajty w systemie binarnym?

Bajty to fundamentalne jednostki systemu binarnego, składające się z ośmiu bitów, które pełnią kluczową rolę w reprezentacji danych w naszych urządzeniach. Przechowują różnorodne informacje, takie jak:

- znaki,

- liczby całkowite,

- liczby zmiennoprzecinkowe.

W pamięci RAM każdy bajt ma przypisany unikalny adres, co pozwala komputerom szybko uzyskiwać dostęp do potrzebnych danych. Programiści korzystają z bajtów, aby skutecznie kodować znaki, przy użyciu standardów takich jak ASCII. Na przykład litera 'A’ jest reprezentowana przez określoną kombinację bitów. Ułatwia to przechowywanie i wymianę danych w formatach, które są zrozumiałe dla systemów komputerowych.

Bajty odgrywają również istotną rolę w transferze informacji, co jest szczególnie ważne w komunikacji oraz w Internecie. Dla osób zajmujących się informatyką zrozumienie bajtów w systemie binarnym jest niezmiernie istotne. Efektywne zarządzanie danymi w tej postaci jest kluczowe dla sprawnego funkcjonowania nowoczesnych systemów komputerowych. To właśnie dzięki bajtom można skutecznie gromadzić i przetwarzać informacje, co z kolei przyczynia się do postępu technologicznego oraz rozwoju oprogramowania.

Jak liczby binarne reprezentują informacje?

Liczby binarne, składające się z zer i jedynek, są podstawą systemu binarnego. Każda ich kombinacja może oznaczać coś innego, w zależności od kontekstu, w jakim się znajdują. Na przykład w systemach kodowania, takich jak ASCII czy UTF-8, konkretne sekwencje binarne są przypisane do liter, cyfr i symboli specjalnych.

W zakresie multimediów dane binarne przybierają formę:

- obrazów,

- dźwięków,

- filmów.

Różne wartości bitów określają cechy takie jak kolor, jasność czy częstotliwość dźwięku, co pozwala na ich późniejsze odtworzenie. System binarny ma kluczowe znaczenie w kompresji danych, co sprawia, że przechowywanie i przesyłanie informacji w komunikacji elektronicznej staje się znacznie bardziej efektywne.

Dzięki percepcji liczb binarnych komputery potrafią efektywnie przetwarzać i magazynować ogromne ilości danych. Zrozumienie operacji na poziomie poszczególnych bitów oraz ich wpływu na bardziej złożone procesy, takie jak programowanie i tworzenie algorytmów, jest niezwykle istotne. W ten sposób liczby binarne stanowią fundament nowoczesnych technologii i elektronicznej komunikacji, umożliwiając realizację skomplikowanych operacji oraz interakcję z różnorodnymi formatami danych.

Jakie są podstawowe zasady działania na liczbach binarnych?

Zasady funkcjonowania na liczbach binarnych obejmują cztery kluczowe operacje: dodawanie, odejmowanie, mnożenie i dzielenie. Chociaż są one analogiczne do działań w systemie dziesiętnym, w przypadku binarnym skupiamy się jedynie na dwóch cyfrach: 0 i 1.

Dodawanie bitów polega na sumowaniu ich wartości. Kiedy sumujemy dwa 1, otrzymujemy 0, a 1 przenosimy do wyższej potęgi. Przykładowo, dodanie 1010 (co odpowiada 10 w systemie dziesiętnym) do 1100 (12 w tym samym systemie) daje wynik 10110, czyli 22.

Odejmowanie w systemie binarnym również działa w podobny sposób. Jeśli od 0 odejmiemy 1, musimy pożyczyć z wyższej potęgi. Na przykład, operacja 1010 (10) minus 0110 (6) prowadzi nas do wyniku 0100 (4).

Mnożenie w systemie binarnym polega głównie na przesuwaniu bitów. Jeśli pomnożymy 101 (czyli 5) przez 11 (3), dodamy 101 przesunięte o jedną pozycję, co ostatecznie daje nam 1111, czyli 15.

Dzielenie binarne jest nieco bardziej skomplikowane. Proces ten przypomina tradycyjne dzielenie w systemie dziesiętnym i wymaga porównania bitów oraz czasami pożyczania, analogicznie do odejmowania.

W świecie binarnym często stosuje się także operacje logiczne, takie jak AND, OR, XOR oraz NOT. Te operacje stanowią fundament algebry Boole’a, mając ogromne znaczenie w programowaniu i tworzeniu algorytmów. Umożliwiają one skuteczne przetwarzanie danych oraz konstrukcję złożonych systemów informatycznych. Zrozumienie zasad działania liczb binarnych jest istotne dla wszystkich, którzy są zaangażowani w technologie komputerowe i programowanie.

Jakie są potęgi liczby 2 w kontekście systemu binarnego?

Potęgi liczby 2 odgrywają kluczową rolę w świecie systemu binarnego. W każdej liczbie binarnej poszczególne cyfry mają przypisaną konkretną potęgę liczby 2, a ich lokalizacja decyduje o wartości. Dzięki temu możliwe jest przekształcanie liczb pomiędzy systemem binarnym a dziesiętnym. Przyjrzyjmy się zatem najważniejszym potęgom liczby 2:

- 2^0 = 1, czyli jednostka,

- 2^1 = 2, co oznacza dwie jednostki,

- 2^2 = 4, znajdujące się na trzeciej pozycji, co odpowiada czterem jednostkom,

- 2^3 = 8, która mieści się na czwartej pozycji,

- 2^4 = 16, piąta pozycja to szesnaście,

- 2^5 = 32,

- 2^6 = 64,

- 2^7 = 128,

- 2^8 = 256 – każda kolejna wartość to podwojenie poprzedniej.

W systemie binarnym cyfra „1” sygnalizuje, że dana potęga jest uwzględniana, natomiast „0” oznacza jej pominięcie. Na przykład, rozważmy liczbę binarną 1101. W niej:

- Pozycja 3 (2^3) ma wartość 1,

- Pozycja 2 (2^2) również wynosi 1,

- Pozycja 1 (2^1) to 0,

- Pozycja 0 (2^0) prezentuje wartość 1.

Aby obliczyć wartość tej liczby, wykonujemy następujące działania: 1*(2^3) + 1*(2^2) + 0*(2^1) + 1*(2^0), co daje 8 + 4 + 0 + 1 = 13 w systemie dziesiętnym. Zrozumienie potęg liczby 2 znacząco ułatwia konwersję pomiędzy tymi systemami liczbowymi, a umiejętność ta jest niezwykle istotna w dziedzinie informatyki oraz programowania.

Jak konwertować liczby binarne na system dziesiętny?

Aby przekształcić liczbę z systemu binarnego na dziesiętny, wykorzystujemy technikę zwaną sumowaniem wag poszczególnych bitów. Każdy bit, czyli cyfra binarna, jest mnożony przez odpowiednią potęgę liczby 2, a następnie sumujemy wyniki. Weźmy na przykład liczbę binarną 1011. Proces konwersji wygląda tak:

- pierwsza cyfra od prawej (1) ma wagę 2^0, co daje wartość 1,

- druga cyfra (1) ma wagę 2^1, czyli 2,

- trzecia cyfra (0) nie przyczynia się do sumy, ponieważ jej wartość wynosi 0,

- ostatnia cyfra (1) ma wagę 2^3, co przekłada się na 8.

Po zsumowaniu tych wartości uzyskujemy: 8 + 0 + 2 + 1 = 11 w systemie dziesiętnym. Ogólny wzór na konwersję prezentuje się następująco:

Liczba w systemie binarnym = (cyfra_n * 2^n) + (cyfra_(n-1) * 2^(n-1)) + … + (cyfra_1 * 2^1) + (cyfra_0 * 2^0). Umiejętność ta jest kluczowa w programowaniu i przetwarzaniu danych, odgrywa istotną rolę w obliczeniach komputerowych oraz w algorytmach decyzyjnych.

Jak system binarny różni się od systemu dziesiętnego?

System binarny różni się od dziesiętnego głównie pod względem cyfr oraz podstawy. W przypadku systemu binarnego ograniczamy się do zaledwie dwóch cyfr: 0 i 1, co czyni go systemem pozycyjnym o podstawie 2. Z kolei system dziesiętny operuje dziesięcioma cyframi, zaczynając od 0, a kończąc na 9, i bazuje na podstawie 10.

W obydwu przypadkach wartość danej cyfry zależy od jej miejsca w liczbie. Na przykład w liczbie binarnej 1101 każdy bit ma przypisaną odpowiednią potęgę liczby 2, natomiast w systemie dziesiętnym cyfry opierają się na potęgach liczby 10.

System binarny stanowi fundamentalny język dla komputerów, co umożliwia im efektywne przetwarzanie oraz przechowywanie danych. Operacje takie jak:

- dodawanie,

- odejmowanie,

- mnożenie,

- dzielenie.

są zupełnie oparte na tych dwóch cyfrach, co odróżnia je od działań w systemie dziesiętnym. Zrozumienie różnic między tymi systemami jest niezwykle ważne w informatyce, zwłaszcza w kontekście operacji na liczbach oraz przeprowadzania konwersji między tymi dwoma systemami. Dlatego umiejętność posługiwania się systemem binarnym ma istotne znaczenie dla programistów oraz inżynierów pracujących w dziedzinie elektroniki cyfrowej.

Dlaczego zera i jedynki są kluczowe w informatyce?

Zera i jedynki odgrywają niezwykle istotną rolę w świecie informatyki, reprezentując podstawowe stany logiczne: włączenie (1) oraz wyłączenie (0). Na tych dwóch wartościach opiera się system binarny, który stanowi fundament działania komputerów. Dzięki tym dwóm stanom maszyny mogą przeprowadzać różnorodne operacje logiczne, niezbędne dla poprawnego funkcjonowania programów i algorytmów.

Zera i jedynki umożliwiają również tworzenie cyfrowych układów, które operują na napięciu elektrycznym, gdzie stany odpowiadają wartościom włączonym lub wyłączonym. To podejście pozwala na realizację sprzętowych implementacji, w których różnorodne urządzenia elektroniczne traktują bity jako podstawowe jednostki informacji. Dlatego znajomość mechanizmu działania zer i jedynek jest niezwykle ważna dla wszystkich specjalistów w branży IT.

Co więcej, nowoczesne technologie, w tym Internet, opierają się na tych elementach. W komunikacji sieciowej dane przesyłane są w postaci ciągów zer i jedynek, co zapewnia szybki i efektywny transfer informacji. W programowaniu natomiast wszystkie operacje oparte są na logicznych działaniach przy użyciu bitów. Można zatem stwierdzić, że zera i jedynki są nie tylko kluczowe dla funkcjonowania sprzętu, ale także stanowią fundament dla bardziej złożonych aplikacji oraz systemów informatycznych.

Jakie zastosowania ma kod binarny?

Kod binarny znajduje szerokie zastosowanie w dziedzinie technologii i informatyki. Przede wszystkim stanowi on podstawę do reprezentacji danych w systemach komputerowych, co z kolei pozwala na ich efektywne przechowywanie oraz przetwarzanie.

W świecie programowania jest on kluczowy dla tworzenia wszelkiego rodzaju oprogramowania, co ma istotne znaczenie dla prawidłowego funkcjonowania aplikacji oraz systemów operacyjnych. Kiedy mówimy o kryptografii, kod binarny staje się nieocenionym narzędziem w procesie szyfrowania i deszyfrowania informacji. Umożliwia on także tworzenie różnorodnych zabezpieczeń, takich jak podpisy cyfrowe, co sprawia, że komunikacja staje się bardziej bezpieczna.

W obliczu cyfrowych zagrożeń, ochrona danych nabiera szczególnego znaczenia. Warto również podkreślić, że kod binarny odgrywa istotną rolę w kompresji multimediów, obejmujących:

- obrazy,

- dźwięki,

- filmy.

Dzięki temu możliwe jest zmniejszenie rozmiaru plików, co ułatwia ich szybkie przesyłanie przez Internet. Na koniec, w dziedzinie elektroniki cyfrowej, kod binarny stanowi fundament dla projektowania skomplikowanych układów cyfrowych oraz procesorów. Dzięki niemu inżynierowie mogą realizować złożone obwody, które wykonują różne operacje matematyczne oraz logiczne, co jest niezbędne w nowoczesnej technologii.

Jak programowanie korzysta z systemu binarnego?

Programowanie opiera się na systemie binarnym, który odgrywa fundamentalną rolę w działaniu dzisiejszych komputerów. Na najniższym poziomie wszelkie instrukcje procesora oraz dane są przedstawiane jako ciągi zer i jedynek. To podstawowy język maszynowy, umożliwiający komputerom realizację operacji na różnych informacjach.

Bity, będące najmniejszymi jednostkami danych w tym systemie, mają kluczowe znaczenie w każdej operacji programistycznej. Programiści wykorzystują je do reprezentacji różnych struktur, na przykład:

- flag,

- masek bitowych.

Dodatkowo posługują się nimi w trakcie wykonywania operacji logicznych, takich jak:

- AND,

- OR,

- NOT.

Dzięki systemowi binarnemu twórcy oprogramowania mają możliwość opracowywania algorytmów, które przetwarzają dane w formacie zrozumiałym i łatwym do użycia dla komputerów. Oprogramowanie korzystające z kodowania binarnego umożliwia tworzenie bardziej złożonych struktur danych, co przyczynia się do większej efektywności operacji.

W dziedzinie architektury komputerowej zrozumienie systemu binarnego jest niezbędne do projektowania wydajnych i zoptymalizowanych aplikacji. W programowaniu istotną rolę odgrywa także konwersja danych pomiędzy różnymi systemami numerycznymi, na przykład:

- binarnym,

- dziesiętnym.

Niezwykle ważne jest również to, że kod binarny stanowi podstawę komunikacji cyfrowej. Informacje przesyłane przez Internet muszą być przekształcane do formatu binarnego, co gwarantuje ich szybki i bezpieczny transfer. Zrozumienie tych zasad stanowi klucz do tworzenia wydajnych i funkcjonalnych aplikacji informatycznych przez każdego programistę.